오늘날 데이터의 양(volume), 다양성(variety), 속도(velocity)는 매우 크기 때문에 ‘빅 데이터(big data)’라는 용어를 사용할 만큼 충분합니다. 일반적인 합의 통계에 따르면, 현재 세계는 매일 약 2.5 크인틸리온 바이트의 데이터를 생성합니다. 이 데이터는 다음 세 가지 형태로 나타납니다:

- 구조화된 데이터(Structured data)는 매우 체계적으로 구성되어 있으며, 신용카드 번호나 GPS 좌표와 같은 미리 정의된 형식으로 존재합니다.

- 비구조화된 데이터(Unstructured data)는 생성된 형태 그대로 존재하며, 소셜 미디어 게시물 등이 해당됩니다.

- 반구조화된 데이터(Semi-structured data)는 구조화된 데이터와 비구조화된 데이터의 혼합 형태로, 각각 이메일 주소와 텍스트 등이 포함됩니다.

데이터는 일반적으로 양적 데이터(quantitative data)와 질적 데이터(qualitative data)로 분류될 수 있습니다. 양적 데이터는 통계 및 비율과 같은 숫자 형태로 제공되는 데이터이며, 질적 데이터는 색상, 냄새, 외관 및 품질과 같은 서술적 특성을 가지는 데이터입니다. 기업은 주 데이터(primary data) 외에도 다른 목적으로 다른 당사자가 수집한 보조 데이터(secondary data)를 사용할 수 있습니다.

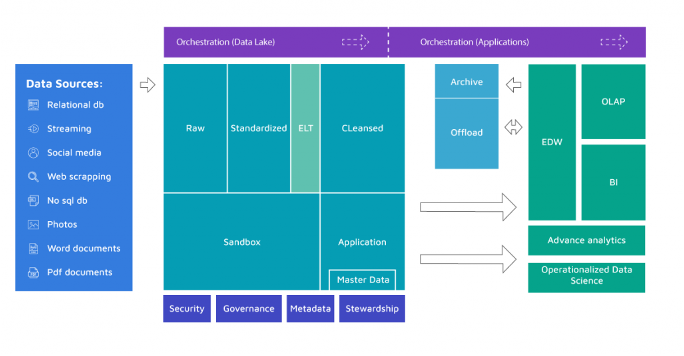

빅 데이터 수집에서는 회사의 데이터 생성 원천을 식별해야 합니다. 전형적인 데이터 원천은 다음과 같습니다:

- 판매점 소프트웨어와 같이 거래 데이터를 생성하는 운영 시스템

- 사물 인터넷(IoT) 생태계 내의 엔드포인트 장치

- 마케팅 회사와 같은 제 2 및 제 3 자원

- 기존 및 잠재적인 고객의 소셜 미디어 게시물

- 스마트폰 위치 데이터와 같은 여러 추가 원천

- 고객에게 직접 정보를 요청하는 설문 조사

기업은 생성되는 모든 데이터를 수집하고 활용할 수 없습니다. 따라서 비즈니스 리더는 기존 및 향후 비즈니스 사용 사례에 필요한 데이터를 식별하는 빅 데이터 수집 프로그램을 구축해야 합니다. 일부 전문가들은 기업이 혁신적인 사용 사례를 시도하기 위해 가능한 많은 데이터를 수집해야 한다고 주장하는 반면, 다른 전문가들은 비용, 복잡성 및 규정 준수 문제를 피하기 위해 선택적으로 데이터를 수집하는 것을 권장합니다.

유용한 데이터 원천을 식별하는 것은 빅 데이터 수집 과정의 시작에 불과합니다. 그 이후로 조직은 데이터를 생성 위치에서 기업 내 위치로 이동시키는 파이프라인을 구축해야 합니다. 이 데이터 적재 과정은 일반적으로 추출(extraction), 변환(transformation), 로드(loading)라는 세 가지 주요 단계로 이루어집니다:

- 추출(extraction): 데이터를 원본 위치에서 가져옵니다.

- 변환(transformation): 데이터를 비즈니스 사용을 위해 정제하고 표준화합니다.

- 적재(loading): 데이터를 데이터베이스, 데이터 웨어하우스 또는 데이터 레이크로 이동하여 사용할 수 있도록

데이터 흐름

흐름 프로세서

- 높은 구성 가능성

- 손실 허용 vs 보장된 전달

- 낮은 지연 시간 vs 높은 처리량

- 동적 우선순위 설정

- 실행 중에 플로우를 수정할 수 있음

- 백 프레셔

- 데이터 프로베넌스

- 시작부터 끝까지 데이터 흐름을 추적

- 확장성을 고려하여 설계됨

- 자체 프로세서 구축 및 기타 기능

- 신속한 개발과 효과적인 테스트 가능

플로우 관리 대시보드

데이터 라우팅, 변환 및 시스템 중재 로직의 강력하고 확장 가능한 방향 그래프. 웹 기반 사용자 인터페이스, 설계, 제어, 피드백 및 모니터링 사이에서 원활한 경험을 제공합니다.

데이터 커넥터

다중 데이터 소스 지원으로 사용자가 여러 플랫폼 및 데이터베이스에서 데이터를 통합할 수 있도록 지원합니다.

시각 및 분석

데이터 통합

메시지 플랫폼

- 하루에 수조 개의 이벤트를 처리할 수 있는 분산 이벤트 스트리밍 기술입니다. 처음에는 분산 커밋 로그의 추상화를 기반으로 한 메시징 큐로 고안되었습니다.

- 스트리밍 데이터를 실시간으로 소화하고 처리하는 데 최적화되어 있습니다.

사용자에게 세 가지 주요 기능을 제공합니다.

- 레코드 스트림을 게시하고 구독합니다.

- 레코드 스트림을 레코드가 생성된 순서대로 효과적으로 저장합니다.

- 레코드 스트림을 실시간으로 처리합니다.

데이터 레이크 관리

관리 데이터

아파치 빅데이터 클러스터의 프로비저닝, 관리 및 모니터링을 위해 소프트웨어를 개발하여 빅데이터 관리를 간단하게 만듭니다. 시스템 관리자가 다음을 수행할 수 있도록 합니다:

빅데이터 클러스터 프로비저닝

- 여러 호스트에 대해 빅데이터 서비스를 설치하기 위한 단계별 마법사를 제공합니다.

- 클러스터용 빅데이터 서비스의 구성을 처리합니다.

- 빅데이터 클러스터 관리.

- 전체 클러스터에 걸쳐 빅데이터 서비스를 시작, 중지 및 재구성하는 중앙 관리를 제공합니다.

빅데이터 클러스터 모니터링

- 빅데이터 클러스터의 건강 상태와 상태를 모니터링하는 대시보드를 제공합니다.

- 메트릭 수집을 위해 메트릭 시스템을 활용합니다.

- 시스템 알림을 위한 알림 프레임워크를 활용하여 필요한 경우 (예: 노드 다운, 남은 디스크 공간 부족 등) 주의가 필요할 때 알려줍니다.

데이터 플랫폼

- 선형 및 모듈식 확장성. 엄격한 일관된 읽기 및 쓰기. 테이블의 자동 및 구성 가능한 샤딩.

- RegionServer 간의 자동 장애 조치 지원. 클라이언트 액세스를 위한 사용하기 쉬운 Java API. 실시간 쿼리를 위한 블록 캐시와 블룸 필터.

- 데이터 웨어하우스 소프트웨어는 SQL을 사용하여 분산 스토리지에 있는 대용량 데이터셋의 읽기, 쓰기, 관리를 용이하게 합니다. 구조는 이미 저장된 데이터에 투영될 수 있습니다. 명령 줄 도구와 JDBC 드라이버가 제공됩니다.